Home / Nosso Blog

Leve seu marketing digital para o próximo nível com estratégias baseadas em dados e soluções inovadoras. Vamos criar algo incrível juntos!

Acompanhe semanalmente nosso canal no youtube com vídeos de marketing e performance e se inscreva-se

Pesquisadores da Anthropic investigaram a capacidade do Claude 3.5 Haiku de decidir quando quebrar uma linha de texto dentro de uma largura fixa, uma tarefa que exige que o modelo rastreie sua posição enquanto escreve. O estudo produziu o resultado surpreendente de que os modelos de linguagem formam padrões internos semelhantes à consciência espacial que os humanos usam para rastrear a localização no espaço físico.

Andreas Volpini twittou sobre este artigo e fiz uma analogia com a fragmentação de conteúdo para consumo de IA. Num sentido mais amplo, o seu comentário funciona como uma metáfora de como tanto os escritores como os modelos navegam na estrutura, encontrando coerência nas fronteiras onde um segmento termina e outro começa.

Este trabalho de pesquisa, no entanto, não trata da leitura de conteúdo, mas da geração de texto e da identificação de onde inserir uma quebra de linha para ajustar o texto a uma largura fixa arbitrária. O objetivo de fazer isso foi entender melhor o que está acontecendo dentro de um LLM, pois ele monitora a posição do texto, a escolha das palavras e os limites de quebra de linha durante a escrita.

Os pesquisadores criaram uma tarefa experimental de gerar texto com quebra de linha em largura específica. O objetivo era entender como o Claude 3.5 Haiku decide quais palavras cabem em uma largura especificada e quando inserir uma quebra de linha, o que exigia que o modelo rastreasse a posição atual dentro da linha de texto que está gerando.

O experimento demonstra como os modelos de linguagem aprendem a estrutura a partir de padrões de texto sem programação ou supervisão explícita.

A tarefa de quebra de linha exige que o modelo decida se a próxima palavra caberá na linha atual ou se deve iniciar uma nova. Para ter sucesso, o modelo deve aprender a restrição de largura de linha (a regra que limita quantos caracteres cabem em uma linha, como no espaço físico de uma folha de papel). Para fazer isso, o LLM deve rastrear o número de caracteres escritos, calcular quantos restam e decidir se a próxima palavra cabe. A tarefa exige raciocínio, memória e planejamento. Os pesquisadores usaram gráficos de atribuição para visualizar como o modelo coordena esses cálculos, mostrando características internas distintas para a contagem de caracteres, a próxima palavra e o momento em que uma quebra de linha é necessária.

Os pesquisadores observaram que Claude 3.5 Haiku representa a contagem de caracteres de linha não como uma contagem passo a passo, mas como uma estrutura geométrica suave que se comporta como uma superfície continuamente curvada, permitindo que o modelo rastreie a posição de forma fluida (em tempo real), em vez de contar símbolo por símbolo.

Outra coisa interessante é que eles descobriram que o LLM desenvolveu um cabeçote de limite (um “cabeçote de atenção”) que é responsável por detectar o limite da linha. Um mecanismo de atenção avalia a importância do que está sendo considerado (tokens). Uma cabeça de atenção é um componente especializado do mecanismo de atenção de um LLM. O cabeçote de limite, que é um cabeçote de atenção, é especializado na tarefa restrita de detectar o limite do fim da linha.

O artigo de pesquisa afirma:

“Uma característica essencial da representação de contagens de caracteres de linha é que a “cabeça de limite” torce a representação, permitindo que cada contagem emparelhe com uma contagem um pouco maior, indicando que o limite está próximo. Ou seja, há um mapa linear QK que desliza a curva de contagem de caracteres ao longo de si. Tal ação não é admitida por incorporações genéricas de alta curvatura do círculo ou do intervalo como aquelas no modelo físico que construímos. Mas está presente tanto na variedade que observamos no Haiku quanto, como agora mostrar, na construção de Fourier “.

Os pesquisadores descobriram que Claude 3.5 Haiku sabe quando uma linha de texto está quase chegando ao fim comparando dois sinais internos:

Os chefes de atenção de limite mencionados acima decidem em quais partes do texto focar. Algumas dessas cabeças são especializadas em detectar quando a linha está prestes a atingir seu limite. Eles fazem isso girando levemente ou alinhando os dois sinais internos (a contagem de caracteres e a largura máxima da linha) para que, quando quase coincidirem, a atenção do modelo se desloque para a inserção de uma quebra de linha.

Os pesquisadores explicam:

“Para detectar um limite de linha se aproximando, o modelo deve comparar duas quantidades: a contagem atual de caracteres e a largura da linha. Encontramos cabeças de atenção cuja matriz QK gira um coletor de contagem para alinhá-lo com o outro em um deslocamento específico, criando um grande produto interno quando a diferença das contagens cai dentro de um intervalo alvo. Múltiplas cabeças com deslocamentos diferentes trabalham juntas para estimar com precisão os caracteres restantes. “

Nesta fase do experimento, o modelo já determinou o quão próximo está do limite da linha e qual será o comprimento da próxima palavra. A última etapa é usar essas informações.

Veja como é explicado:

“A etapa final da tarefa de quebra de linha é combinar a estimativa do limite da linha com a previsão da próxima palavra para determinar se a próxima palavra caberá na linha ou se a linha deve ser quebrada.”

Os pesquisadores descobriram que certos recursos internos do modelo são ativados quando a próxima palavra faz com que a linha exceda seu limite, servindo efetivamente como detectores de limite. Quando isso acontece, o modelo aumenta a chance de prever um símbolo de nova linha e diminui a chance de prever outra palavra. Outros recursos fazem o oposto: são ativados quando a palavra ainda cabe, diminuindo a chance de inserir uma quebra de linha.

Juntas, essas duas forças, uma pressionando pela quebra de linha e outra impedindo-a, se equilibram para tomar a decisão.

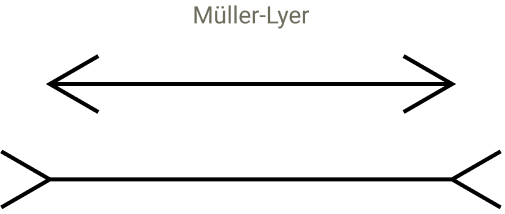

A próxima parte da pesquisa é incrível porque eles se esforçaram para testar se o modelo poderia ser suscetível a ilusões visuais que poderiam causar tropeços. Eles começaram com a ideia de como os humanos podem ser enganados por ilusões visuais que apresentam uma perspectiva falsa que faz com que linhas do mesmo comprimento pareçam ter comprimentos diferentes, uma mais curta que a outra.

Os pesquisadores inseriram tokens artificiais, como “@@”, para ver como eles perturbavam o senso de posição do modelo. Esses testes causaram desalinhamentos nos padrões internos do modelo usado para monitorar a posição, semelhantes às ilusões visuais que enganam a percepção humana. Isso fez com que o sentido dos limites das linhas do modelo mudasse, mostrando que sua percepção da estrutura depende do contexto e dos padrões aprendidos. Mesmo que os LLMs não vejam, eles experimentam distorções na sua organização interna, semelhantes à forma como os humanos julgam mal o que vêem, perturbando as cabeças de atenção relevantes.

Eles explicaram:

“Descobrimos que ele modula o próximo token previsto, interrompendo a previsão da nova linha! Conforme previsto, as cabeças relevantes se distraem: enquanto com o prompt original, as cabeças atendem de nova linha em nova linha, no prompt alterado, as cabeças também atendem ao @@.”

Eles se perguntaram se havia algo especial nos caracteres @@ ou se algum outro caracter aleatório atrapalharia a capacidade do modelo de concluir a tarefa com êxito. Então, eles realizaram um teste com 180 sequências diferentes e descobriram que a maioria delas não atrapalhava a capacidade do modelo de prever o ponto de quebra da linha. Eles descobriram que apenas um pequeno grupo de caracteres relacionados ao código era capaz de distrair as cabeças de atenção relevantes e interromper o processo de contagem.

O estudo mostra como os recursos baseados em texto evoluem para sistemas geométricos suaves dentro de um modelo de linguagem. Também mostra que os modelos não apenas processam símbolos, mas também criam mapas baseados na percepção a partir deles. Essa parte, sobre percepção, é para mim o que há de realmente interessante na pesquisa. Eles continuam voltando às analogias relacionadas à percepção humana e como essas analogias continuam se ajustando ao que eles veem acontecendo dentro do LLM.

Eles escrevem:

“Embora às vezes descrevamos as primeiras camadas dos modelos de linguagem como responsáveis pela” destokenização “da entrada, talvez seja mais evocativo pensar nisso como percepção. O início do modelo é realmente responsável por ver a entrada, e muitos dos primeiros circuitos estão a serviço da detecção ou percepção do texto, semelhante à forma como as primeiras camadas nos modelos de visão implementam a percepção de baixo nível. “

Então, um pouco mais tarde, eles escrevem:

“Os padrões geométricos e algorítmicos que observamos têm paralelos sugestivos com a percepção em sistemas neurais biológicos. … Essas características exibem dilatação – representando contagens de caracteres cada vez maiores, ativadas em intervalos cada vez maiores – espelhando a dilatação das representações numéricas em cérebros biológicos. Além disso, a organização das características em uma variedade de baixa dimensão é um exemplo de um motivo comum na cognição biológica. Embora as analogias não sejam perfeitas, suspeitamos que ainda haja uma sobreposição conceitual frutífera devido ao aumento da colaboração entre neurociência e interpretabilidade.”

Veja também: Como os LLMs interpretam o conteúdo: como estruturar informações para pesquisa de IA

Arthur C. Clarke escreveu que a tecnologia avançada é indistinguível da magia. Acho que uma vez que você entende uma tecnologia, ela se torna mais identificável e menos mágica. Nem todo conhecimento tem uso utilitário e acho que entender como um LLM percebe o conteúdo é útil na medida em que não é mais mágico. Esta pesquisa tornará você um SEO melhor? Aprofunda a nossa compreensão de como os modelos de linguagem organizam e interpretam a estrutura do conteúdo, tornando-o mais compreensível e menos mágico.

Leia sobre a pesquisa aqui:

Quando os modelos manipulam variedades: a geometria de uma tarefa de contagem

Imagem em destaque por Shutterstock/Krot_Studio

”Negócio desatualizado ele não está apenas perdendo dinheiro, mas está perdendo a chance de fazer a diferença ao mundo”

Produtor