Home / Nosso Blog

Leve seu marketing digital para o próximo nível com estratégias baseadas em dados e soluções inovadoras. Vamos criar algo incrível juntos!

Acompanhe semanalmente nosso canal no youtube com vídeos de marketing e performance e se inscreva-se

O OpenAI divulgou o maior estudo até o momento sobre como os usuários realmente usam o chatgpt. Eu sintetizei meticulosamente os que você e eu deveria pagar, para que você não precise percorrer a infinidade de idéias úteis e sem sentido.

Crédito da imagem: Harry Clarkson-Bennett

Crédito da imagem: Harry Clarkson-BennettUm chatbot é um modelo estatístico treinado para gerar uma resposta de texto, dada alguma entrada de texto. Macaco, veja, o macaco faça.

Os chatbots mais avançados têm um processo de treinamento de dois ou mais estágios. Em estágio um (menos conhecido coloquialmente como “pré-treinamento”), os LLMs são treinados para prever a próxima palavra em uma string.

Como o melhor contador do mundo, ambos são previsíveis e chatos. E isso não é necessariamente uma coisa ruim. Quero meus chefs gordos, meus pilotos sóbrios e meus homens, tão chatos que eles são os próximos na fila para liderar a festa verde.

Estágio dois é onde as coisas ficam um pouco mais sofisticadas. Na fase de “pós-treinamento”, os modelos são treinados para gerar respostas de “qualidade” a um prompt. Eles são ajustados em diferentes estratégias, como o aprendizado de reforço, para ajudar a classificar as respostas.

Com o tempo, os LLMs, como o cachorro de Pavlov, são recompensados ou repreendidos com base na qualidade de suas respostas.

Na primeira fase, o modelo “entende” (definitivamente em vírgulas invertidas) uma representação latente do mundo. Na segunda fase, seu conhecimento é aprimorado para gerar a melhor resposta da qualidade.

Sem as configurações de temperatura, o LLMS gerará exatamente a mesma resposta, uma vez após o tempo, desde que o processo de treinamento seja o mesmo.

Temperaturas mais altas (mais próximas de 1,0) aumentam a aleatoriedade e a criatividade. As temperaturas mais baixas (mais próximas de 0) tornam o (s) modelo (s) muito mais preditivo e preciso.

Portanto, seu caso de uso determina as configurações de temperatura apropriadas. A codificação deve ser definida mais próxima de zero. Tarefas criativas e mais focadas no conteúdo devem estar mais próximas de uma.

Eu já falei sobre isso no meu artigo sobre como construir uma marca post ai. Mas eu recomendo ler isso guia muito bom sobre como as escalas de temperatura funcionam com o LLMS e como eles afetam a base de usuários.

Que os LLMs não são um substituto direto para a pesquisa. Nem mesmo tão perto da IMO. Este estudo SEMRUSH destacou que os super usuários do LLM aumentou A quantidade de pesquisas tradicionais que eles estavam fazendo. A teoria da expansão parece ser verdadeira.

Mas eles trouxeram uma mudança fundamental na maneira como as pessoas acessam e interagem com as informações. As interfaces de conversação têm valor incrível. Particularmente em um formato no local de trabalho.

Quem sabia que éramos tão preguiçosos?

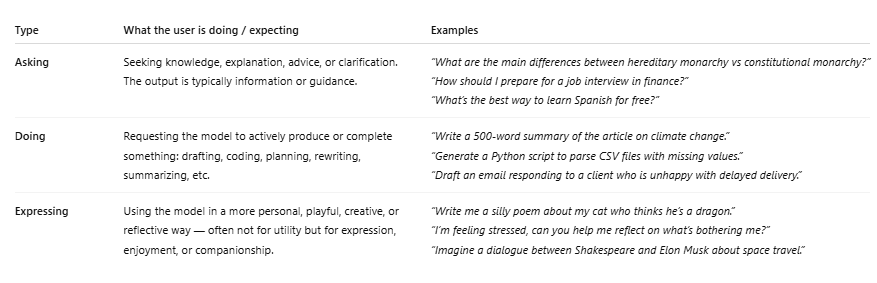

Esses três principais casos de uso representam 80% de todas as conversas humanas-robôs. Orientação prática, buscando informações e, por favor, ajude -me a escrever algo sem graça e sem qualquer tipo de paixão ou insight, robô maravilhoso.

Vou admitir que a maioria das consultas de redação é para editar o trabalho existente. Ainda. Se eu ler algo escrito por IA, vou me sentir enganado. E o engano não é uma qualidade atraente.

Conheço pessoas suficientes que apenas usam o LLMS para ajudá -las a escrever e -mails melhores. Quase sinto pena dos Bros da Tech que os principais casos de uso dessas ferramentas não tenham uma criatividade.

*Comparado com 33% das conversas de Claude relacionadas ao trabalho.

É importante observar que outros estudos têm algumas tomadas muito diferentes sobre o que as pessoas usam o LLMS. Portanto, isso não é tão cortado e seco quanto pensamos. Tenho certeza de que as coisas continuarão a mudar.

Claro, nós, homens, temos nossas falhas. Ao longo da história, talvez tenhamos sido um pouco rápido em lutar e um pouco dominando. Mas é bom ver a paridade.

Uma mesa construída com ChatGPT com exemplos de cada tipo de consulta-perguntando, fazendo e expressando (Crédito da imagem: Harry Clarkson-Bennett)

Uma mesa construída com ChatGPT com exemplos de cada tipo de consulta-perguntando, fazendo e expressando (Crédito da imagem: Harry Clarkson-Bennett)Eu não acho que o LLMS seja um desastre para os editores. Claro, eles não enviam nenhum tráfego de referência e começaram a remover citações fora dos usuários pagos (clássicos). Mas nenhum desses chefes de tecnologia vai nos dar qualquer coisa.

É uma corrida para a lua, e somos o cachorro que eles enviaram no voo de teste.

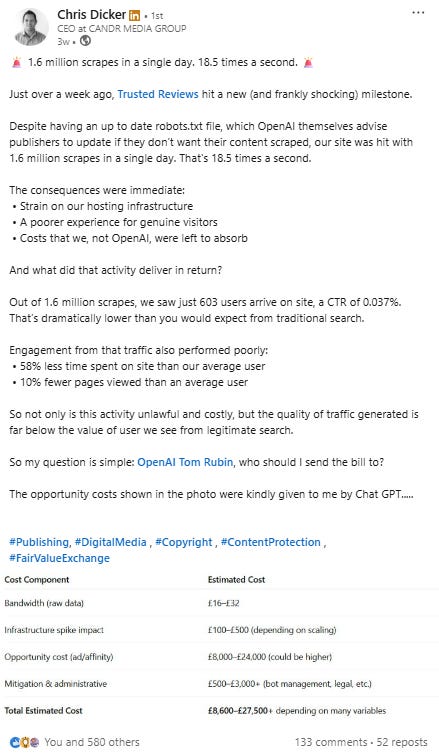

Mas se você é um editor com uma opinião, uma audiência e – espero – alguma profundidade e ativos da marca, você ficará bem. Embora O comportamento de rastreamento deles está ficando fora de controle.

Tráfego de qualidade de merda e não muito disso (Crédito da imagem: Harry Clarkson-Bennett)

Tráfego de qualidade de merda e não muito disso (Crédito da imagem: Harry Clarkson-Bennett)Um dos resultados mais práticos que nós, como editores, podemos tirar desses dados, é a aparente mudança nas intenções. Durante as eras, fomos atrelados com navegação, informativa, comercial e transacional.

Agora temos feito. Ou geração. E é enorme.

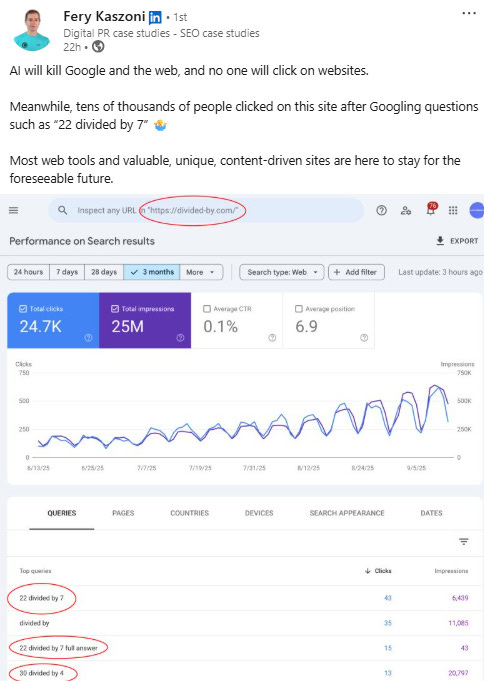

Mesmo ferramentas simples ainda podem gerar tráfego e receita fantásticos (crédito da imagem: Harry Clarkson-Bennett)

Mesmo ferramentas simples ainda podem gerar tráfego e receita fantásticos (crédito da imagem: Harry Clarkson-Bennett)O SEO não está morto para os editores. Mas precisamos fazer mais do que apenas continuar publicando conteúdo. Há muito a ser dito para defender os valores da IA, mantendo -o à distância.

Pensar BBC Verifique. Conteúdo que não pode ser sintetizado por máquinas porque agrega muito valor. Ferramentas e ativos vinculáveis. Opiniões reais de especialistas pressionaram.

Mas é difícil escalar essa qualidade. O SEO programático pode gerar um valor incrível. Como podem ferramentas. As ferramentas que respondem aos usuários “fazer” consultas várias vezes. Temos que construir coisas que agregam valor fora do corpus existente.

E se o seu público é geralmente mais jovem e confiante, você terá que se inclinar mais nisso.

Mais recursos:

Este post foi publicado originalmente em Liderança em SEO.

Imagem em destaque: Roman Samborskyi/Shutterstock

”Negócio desatualizado ele não está apenas perdendo dinheiro, mas está perdendo a chance de fazer a diferença ao mundo”

Produtor

Nossa solução traz para você um plano 100% personalizado de acordo com o seu projeto e com isso fazemos essa apresentação online em uma reunião de 20 a 40 minutos quer receber esse diagnóstico para sua empresa entre em contato via whatsapp !